本報訊

TikTok母公司字節跳動(ByteDance)展示最新人工智能模型OmniHuman,單憑一張照片就能生成栩栩如生的影片,顯示相片中人說話、做手勢、唱歌和演奏樂器。

據《福布斯》(Forbes)報道,OmniHuman-1項目頁面稱:「OmniHuman明顯超越現有方法,能夠基於微弱的訊號輸入,尤其是音訊,來生成極為逼真的人像影片」。OmniHuman「支援任何長寬比的圖像輸入,不管是人像、半身或全身圖像,都可以在各種場景中提供更逼真又高品質的結果」。有關OmniHuman的研究論文日前在論文預印本網站arXiv刊登。

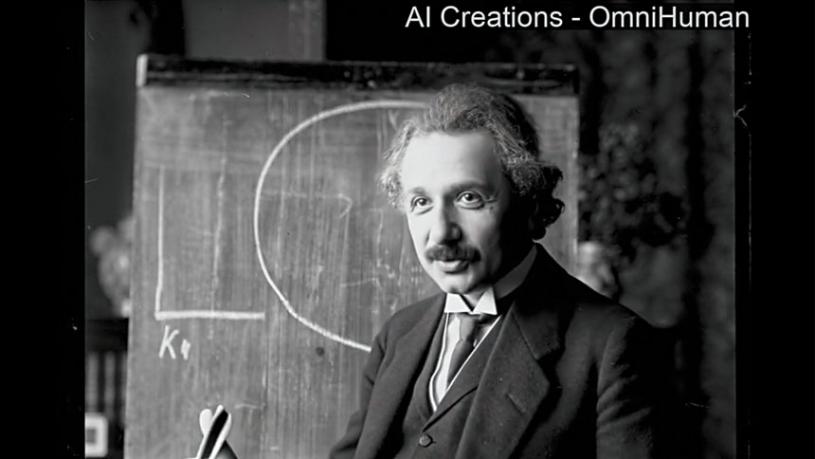

模型尚未對外公開,但在OmniHuman-1項目頁面上,研究員分享了顯示這工具能力的示範短片,展示了從多個角度看到的手部和身體動作、動畫人物、動物和栩栩如生被還原的歷史人物。

在一部清晰的黑白片中,愛因斯坦在一塊黑板前說話,用手勢和微妙的面部表情強調他的話,儼如回到過去看著這位著名理論學家進行大學演講。

字節跳動團隊利用1萬8700多個小時的真人影片數據訓練OmniHuman,當中結合文字、音訊和身體姿勢等不同類型的輸入,但該公司未回應訓練數據的具體內容。

南加州大學傳播系臨床助理教授納格爾(Freddy Tran Nager)看完示範影片後形容,這些影片在一個小螢幕上的效果「非常令人深刻」。

《福布斯》指出,這工具使字節跳動和TikTok在激烈競爭的AI競賽中佔據一席之地,創造出最優質且最逼真的影片。

納格爾表示,可以預期像OmniHuman這類系統,將用於教育環境,讓師生使用。又指由於OmniHuman與TikTok的關係,可以想象會有內容創作者會用它製作虛擬版本的自己,讓自己休息一下。

新興技術行銷顧問公司PitchFWD創辦人沃爾夫(Samantha G. Wolfe)也看到OmniHuman等工具的前景和潛在危險,「從科技角度來看,僅憑一張圖片就能創造出一些東西看起來真的會說話和會動確實令人著迷,但也可能有負面後果」,例如佯裝商業或政治領袖說出非準確的話可能對企業以至國家產生巨大影響。