隨著人工智能(AI)公司面臨越來越大的壓力,需要加強保護未成年用戶免受傷害,聊天機器人平台Character.AI宣布,將不再允許青少年與其聊天機器人互動。

該公司稱,將移除18歲以下用戶在其平台上與AI進行任何開放式聊天的功能,將於11月25日生效。

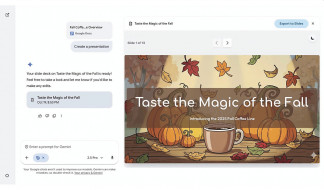

在生效之前,Character.AI將為用戶提供全新的「18歲以下體驗」,鼓勵青少年將聊天機器人用於創意用途,例如製作影片或串流內容,而非尋求陪伴。為了協助使用者逐步過渡,目前未滿18歲的使用者每天僅能與機器人互動最長兩小時,並將在11月底新規生效前進一步縮短。

Character.AI也推出一款內部開發的年齡驗證工具,聲稱將「確保用戶獲得與其年齡相符的適當體驗」。除此之外,該公司還成立了一間「AI安全實驗室」,希望促進讓其他公司、研究人員和學者共享見解,並合作改進AI的安全措施。

Character.AI表示,在聽取監管機構、行業專家和憂心忡忡的家長們的意見後推出這些新措施。聯邦貿易委員會(FTC)近期對對提供聊天機器人陪伴服務的AI公司展開正式調查,Character.AI是其中之一,其他公司還包括Meta AI、OpenAI及Snap。

今年夏天,Meta AI和Character AI受到德州檢察長帕克斯頓(Ken Paxton)的審查。

帕克斯頓表示,這兩個平台上的聊天機器人可能會「以專業治療工具的身分自居」,但其實不具備必須的資格。

為了平息這場爭議,Character.AI的執行長阿南德(Karandeep Anand)表示,該公司的新策略方向,將從AI陪伴服務,轉型為以創作為核心的「角色扮演平台」,而非僅追求與用戶進行對話。本報訊